Some technologies I'd never heard of but probably should have:

Unitex - a corpus-processing system

Nooj - a linguistic development environment

INTEX - a linguistic development environment

Un carnet de bord des mémoires : M2 Sciences du Langage, M1 Communication

[Blog of my Master's theses projects.]

samedi 24 mars 2012

vendredi 23 mars 2012

Notes de lecture : Degenne, Alain (1997) "Quelques modèles en analyse des réseaux sociaux: Présentation du numéro" Mathématiques et sciences humaines, tome 137, p. 5-9

****ce post est toujours en construction****

[PDF]

Un numéro de Mathématiques et sciences humaines (tome 137 - il n'y a pas de titres propres) trait particulièrement l'analyse des réseaux sociaux (dans le sens large - c.a.d. pas forcement numérique - du terme).

Dans l'introduction du numéro, Alain Degenne parle brièvement des relations entre les sciences humaines et les mathématiques sur les question d'analyse. Il présente quelques méthodes de collecte des données, et méthodes de représentation des données.

Etat de la discipline

Il présente l'état de la discipline (au moment qu'il écrivait) comme dérivant de de grandes traditions :

(mon illustration)

Je n'ai toujours pas assez de bases et références pour pouvoir dire au quel point cela est toujours le cas à l'heure actuelle.

Sciences humaines et mathématiques

Les théories élaborées par des mathématiciens n'ont pas eu beaucoup de succès auprès des sociologues (dans Faust et Wasserman (1994), "on n'y trouve aucune référence à des notions dotées de propriétés algébriques fortes").

Je suis plus ou moins certaine que cela n'est plus le cas aujourd'hui.

La représentation graphique des réseaux

Comment dessiner, par exemple, la graphe des citations entre auteurs dans des articles scientifiques? (Travaux sur ces relations: White, Boorman, Breiger, 1976: tout le monde cite les plus connus, personne cite les débutants, etc.)

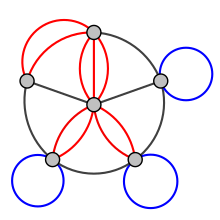

Si chaque noeud est un auteur, on peut dessiner des graphes comme ceux-là:

(source de l'image)

Mais comment prendre en compte d'autres données - les caractéristiques des auteurs (âge, diplômes, universités, etc.), les caractéristiques des relations (les dates des citations) - qui seront, aussi, importants pour l'analyse?

Possibilités :

[source de l'image]

[PDF]

Un numéro de Mathématiques et sciences humaines (tome 137 - il n'y a pas de titres propres) trait particulièrement l'analyse des réseaux sociaux (dans le sens large - c.a.d. pas forcement numérique - du terme).

Dans l'introduction du numéro, Alain Degenne parle brièvement des relations entre les sciences humaines et les mathématiques sur les question d'analyse. Il présente quelques méthodes de collecte des données, et méthodes de représentation des données.

Etat de la discipline

Il présente l'état de la discipline (au moment qu'il écrivait) comme dérivant de de grandes traditions :

(mon illustration)

Je n'ai toujours pas assez de bases et références pour pouvoir dire au quel point cela est toujours le cas à l'heure actuelle.

Sciences humaines et mathématiques

Les théories élaborées par des mathématiciens n'ont pas eu beaucoup de succès auprès des sociologues (dans Faust et Wasserman (1994), "on n'y trouve aucune référence à des notions dotées de propriétés algébriques fortes").

Je suis plus ou moins certaine que cela n'est plus le cas aujourd'hui.

La représentation graphique des réseaux

Comment dessiner, par exemple, la graphe des citations entre auteurs dans des articles scientifiques? (Travaux sur ces relations: White, Boorman, Breiger, 1976: tout le monde cite les plus connus, personne cite les débutants, etc.)

Si chaque noeud est un auteur, on peut dessiner des graphes comme ceux-là:

(source de l'image)

Mais comment prendre en compte d'autres données - les caractéristiques des auteurs (âge, diplômes, universités, etc.), les caractéristiques des relations (les dates des citations) - qui seront, aussi, importants pour l'analyse?

Possibilités :

- Des multigraphes colorés (Ove Frank)

[source de l'image]

- Multilevel Modelling (Degenne ne cite pas l'ouvrage dans sa bibliographie (ni "multilevel modelling"), mais j'imagine qu'il pense à Snijders, Spreen, Zwaagstra (1995), "The Use of Multilevel Modeling for Analysing Personal Networks: Networks of Cocaine Users in an Urban Area", Journal of Quantitative Anthropology, vol. 5, n°1, P. 85-105.

Il faudra que j'aille voir cet article en plus de détail, mais il y a déjà une chose que Deganne a relevé: Snijders, Spreen et Zwaagstra créent la distinction entre "réseaux complets" et "réseaux personnels" :

Réseau complet: population limitée, pour une relation donnée

(peut se representer par une graphe/multigraphe, simple/coloré/valué)

Question de la collecte des données

Les questions que j'ai (dans le cadre de mon mémoire) à propos de la collecte des données (qui choisir? quel réseau?) ne sont pas nouveaux. Quand "réseau social" ne se referait pas au numérique, la question s'est posé (même, encore plus?) de comment choisir ses participants.

Quelques possibilités:

"A complete network refers to a group of individ uals and one or more types of relation, and the data indicates, for every pair of individuals, whether or not the relation is present between them. A personal or egocentric network refers to one central individual, indicated as ego, the respondent, or the focal individual; the other individuals with whom ego has a relation of the considered type together constitute ego's personal network. These other individuals are referred to as aIters and also, in their relation to the respondent, as nominees. The usual type of personal network data consists of a sample of respondents, wherein for each respondent, all relations in his personal network are identified."Je continue à citer l'article de 1995, pour les parties que Degenne a traduit, et un peu plus:

(.....je reviendrais là-dessus)"Many statistical methods are available for the analysis of complete network data; [...] This is not the case for the analysis of personal networks. Personal network data distinguish themselves from other types of data in two aspects: first, the mutual dependence of the various relations of each single respondent; and second, the fact that diverse kinds of variables may be present. Variables can be attributes of individual respondents, of individual nominees, or of dyadic respondent-nominee relationships. Variables that refer, through an aggregation procedure, to the entire personal network, e.g., the number of relations mentioned by ego, are considered here as attributes of ego. For questions where the dependent variable as well as the explanatory (independent) variables are attributes of the focal individual, traditional statistical methods, such as OLS regression analysis, can be used. Examples are studies of the size and composition of social networks, and studies of the effect of social support on health. For such questions, the unit of analysis is ego together with his personal network; characteristics of the personal network can be included in the analysis by aggregating characteristics of relations to the level of the personal network. This procedure is often followed, an example is Campbell and Lee (1992; see p. 1085). However, aggregation of haracteristics of relations to the level of the personal network is not always satisfactory, especially when the dependent variable is itself a function of the personal network."

Réseau complet: population limitée, pour une relation donnée

(peut se representer par une graphe/multigraphe, simple/coloré/valué)

Question de la collecte des données

Les questions que j'ai (dans le cadre de mon mémoire) à propos de la collecte des données (qui choisir? quel réseau?) ne sont pas nouveaux. Quand "réseau social" ne se referait pas au numérique, la question s'est posé (même, encore plus?) de comment choisir ses participants.

Quelques possibilités:

- Héran, (1987, 1988) "contacts entre les personnes" : (prendre des individus de façon aléatoire. pour chaque individu, demande qu'il enregistre tous ses personnes avec qui il entre en contacte, les caractéristiques de ces personnes et la nature de l'interaction)

- Snijders, Spreen - inspiré par "random walk strategy"

Problèmes:

* Procédure s'est montré difficile à exécuter en France

* Utilité de ces informations??!

- Autres travaux de Snijders: sondage par boule de neige

mardi 20 mars 2012

Conférence au BPI, "Le parler jeunes. Un danger pour la langue française?"

Dans le cadre de la "semaine de la langue française", une conférence a été animé au BPI par Cyril Trimaille (avec Françoise Gadet, Maria Candea, Marie-Madeleine Bertucci et Boris Seguin) sur "Le parler des jeunes". Sous-titre: "Un danger pour la langue française?"

Une vidéo de la conférence a été transmis en direct vis le site web, et, si je ne me trompe pas, un enregistrement sera disponible dans les archives sonores de la BPI la semaine prochaine.

Ce contexte grand-public a été l'occasion de faire un tour rapide des filières de recherche qui prennent comme objet cette variation linguistique qu'on appel le "parler jeunes".

C'était aussi l'occasion pour des échanges entre universitaires et "grand public" - chose qui a, je crois, été bien enrichissement pour tout le monde.

Quelques commentaires entendus (est-ce que je les ai bien notés? on verra dans une semaine avec l'audio!):

Une vidéo de la conférence a été transmis en direct vis le site web, et, si je ne me trompe pas, un enregistrement sera disponible dans les archives sonores de la BPI la semaine prochaine.

Ce contexte grand-public a été l'occasion de faire un tour rapide des filières de recherche qui prennent comme objet cette variation linguistique qu'on appel le "parler jeunes".

C'était aussi l'occasion pour des échanges entre universitaires et "grand public" - chose qui a, je crois, été bien enrichissement pour tout le monde.

Quelques commentaires entendus (est-ce que je les ai bien notés? on verra dans une semaine avec l'audio!):

"Je trouve ça pas très bien [...] la langue française est en déclin [...] c'est les chat est les sms"

"L'avenir de la langue française se trouve en Afrique"

"Si ma langue maternelle était l'anglais je serais plus inquiète" (ça, je n'ai pas compris..)

vendredi 16 mars 2012

Twitter-scraping with Python for Dummies (in Windows)

I'm ok with Python but it took me a while to get this set up, and all the "easy guides" seem to start from Linux.

Compiled from a couple of pages, and some trial and error.

You will need:

Step 1: Get your Twitter Api key

You will need to be a twitter user to get an api key. You will need an api key for some of the things you'll do later. You don't absolutely need to do this step right now but it's probably eaiser.

This explains the process pretty clearly When you're filling out the form, it doesn't matter what you put in the fields for "app name" and "website", etc.

You will also need the access token, so click on the button at the bottom of the page to get that.

Also, go into your settings (there should be a tab at the top of the page), scroll down to 'Application Type' and choose 'Read and Write'. This will mean you can update your twitter status, and things like that. (Then, obviously, scroll down and click on 'Update this Twitter application's settings')

If you'd already created your access token before doing this, you will need to re-do that to update it with the new permissions. Click 'Recreate my access token'.

Step 2: Download the python wrapper for the twitter api and its dependencies

Open up a Command Prompt

( Start->Accessories->Command Prompt )

Type: cd c:\Python27\scripts

Type: easy_install simplejson

(wait. read what's on the screen - hopefully not an error)

Type: easy_install httplib2

(wait, etc)

Type: easy_install oauth2

(wait, etc)

Type: easy_install twitter

(wait, etc - and if that doesn't work, try: easy_install pip

then: pip install twitter )

You should now be good to go.

Step 2: Setting up the twitter api wrapper in python

Open up a Python shell window. You should get this if you go :

Start -> Programs -> Python27 -> IDLE (Python Gui)

It should look like this:

Type: import twitter

(nothing happens)

Type: api = twitter.Api()

(nothing happens)

We're now referring to the official documentation here.

Type:

api = twitter.Api(consumer_key='consumer_key',

consumer_secret='consumer_secret',

access_token_key='access_token',

access_token_secret='access_token_secret')

- Except that where it says 'consumer_secret', 'access_token', etc (everything with the single quote marks), write in the Consumer Key / Consumer Secret / etc that you got in Step 1. Keep the quote marks.

Also, you don't need to press Enter between these lines, but it doesn't matter if you do.

To check that that has worked, type:

print api.VerifyCredentials()

When you press Enter you should get a bunch of text (hopefully not any errors).

What would be a good idea right now is to save this script, so that you don't have to go back and remember/retype all of that next time you want to work.

(In the Python Shell window, File->Save)

Step 4: Try a few things out

(These are from the Google Code page):

allstatuses = api.GetPublicTimeline()

print [s.user.name for s in statuses]

statuses = api.GetUserTimeline("user")

(The username is text, so must be in quote marks)

friends = api.GetFriends("user")

print [f.name for f in friends]

(For list of people the user is "following")

and... away you go. full documentation here.

Compiled from a couple of pages, and some trial and error.

You will need:

- Windows (any version, afaik)

- A twitter account where you have confirmed your email address

- Python (2.7)

Step 1: Get your Twitter Api key

You will need to be a twitter user to get an api key. You will need an api key for some of the things you'll do later. You don't absolutely need to do this step right now but it's probably eaiser.

This explains the process pretty clearly When you're filling out the form, it doesn't matter what you put in the fields for "app name" and "website", etc.

You will also need the access token, so click on the button at the bottom of the page to get that.

Also, go into your settings (there should be a tab at the top of the page), scroll down to 'Application Type' and choose 'Read and Write'. This will mean you can update your twitter status, and things like that. (Then, obviously, scroll down and click on 'Update this Twitter application's settings')

If you'd already created your access token before doing this, you will need to re-do that to update it with the new permissions. Click 'Recreate my access token'.

Step 2: Download the python wrapper for the twitter api and its dependencies

Open up a Command Prompt

( Start->Accessories->Command Prompt )

Type: cd c:\Python27\scripts

Type: easy_install simplejson

(wait. read what's on the screen - hopefully not an error)

Type: easy_install httplib2

(wait, etc)

Type: easy_install oauth2

(wait, etc)

Type: easy_install twitter

(wait, etc - and if that doesn't work, try: easy_install pip

then: pip install twitter )

You should now be good to go.

Step 2: Setting up the twitter api wrapper in python

Open up a Python shell window. You should get this if you go :

Start -> Programs -> Python27 -> IDLE (Python Gui)

It should look like this:

Type: import twitter

(nothing happens)

Type: api = twitter.Api()

(nothing happens)

We're now referring to the official documentation here.

Type:

api = twitter.Api(consumer_key='consumer_key',

consumer_secret='consumer_secret',

access_token_key='access_token',

access_token_secret='access_token_secret')

- Except that where it says 'consumer_secret', 'access_token', etc (everything with the single quote marks), write in the Consumer Key / Consumer Secret / etc that you got in Step 1. Keep the quote marks.

Also, you don't need to press Enter between these lines, but it doesn't matter if you do.

To check that that has worked, type:

print api.VerifyCredentials()

When you press Enter you should get a bunch of text (hopefully not any errors).

What would be a good idea right now is to save this script, so that you don't have to go back and remember/retype all of that next time you want to work.

(In the Python Shell window, File->Save)

Step 4: Try a few things out

(These are from the Google Code page):

allstatuses = api.GetPublicTimeline()

print [s.user.name for s in statuses]

statuses = api.GetUserTimeline("user")

(The username is text, so must be in quote marks)

friends = api.GetFriends("user")

print [f.name for f in friends]

(For list of people the user is "following")

and... away you go. full documentation here.

mercredi 14 mars 2012

Glottopol n°10, "Regards sur l'internet, dans ses dimensions langagières. Penser les continuités et discontinuités"

Le numéro 10 (2007) de Glottopol (une revue sociolinguistique en ligne de l'Université de Rouen) a été dédié aux dimensions langagiers de l'internet, en hommage à Jacques Anis.

Deux articles m'ont intéressés particulièrement:

Michel Marcoccia, Nadia Gauducheau (Tech-CICO (ICD, CNRS / Université de technologie de Troyes)) : L'analyse du rôle des smileys en production et en réception : un retour sur la question de l'oralité des écrits numériques

(Ici j'ai quelques remarques critiques, qui seront à venir)

Remi Adam Van Compernolle, Lawrence Williams (University of North Texas): De l'oral à l'électronique : la variation orthographique comme ressource sociostylistique et pragmatique dans le français électronique

Les auteurs comparent trois types de discours électroniques (l'IRC, les forums de discussion et le "clavardage modéré") les uns des autres, et avec du français parlé informel. L'étude se focalise sur la variation dans l'orthographe ou prononciation des séquences équivalents à "il y a", "il faut", "tu es", "tu as", "c'est" et "j'ai". Les résultats montrent que ces discours se différent les uns des autres, et suggèrent que l'IRC ressemble le plus au français parlé informel.

Le point d’intérêt pour moi est la sélection des séquences ("il y a", "il faut", etc) -- me suggérant qu'ils peuvent être une piste d'étude promettant.

Deux articles m'ont intéressés particulièrement:

Michel Marcoccia, Nadia Gauducheau (Tech-CICO (ICD, CNRS / Université de technologie de Troyes)) : L'analyse du rôle des smileys en production et en réception : un retour sur la question de l'oralité des écrits numériques

(Ici j'ai quelques remarques critiques, qui seront à venir)

Remi Adam Van Compernolle, Lawrence Williams (University of North Texas): De l'oral à l'électronique : la variation orthographique comme ressource sociostylistique et pragmatique dans le français électronique

Les auteurs comparent trois types de discours électroniques (l'IRC, les forums de discussion et le "clavardage modéré") les uns des autres, et avec du français parlé informel. L'étude se focalise sur la variation dans l'orthographe ou prononciation des séquences équivalents à "il y a", "il faut", "tu es", "tu as", "c'est" et "j'ai". Les résultats montrent que ces discours se différent les uns des autres, et suggèrent que l'IRC ressemble le plus au français parlé informel.

Le point d’intérêt pour moi est la sélection des séquences ("il y a", "il faut", etc) -- me suggérant qu'ils peuvent être une piste d'étude promettant.

jeudi 1 mars 2012

An afternoon in style on the Internet

Over at Language Log, Mark Liberman writes of the "serendipitous conversational cross-fertilization comes from random encounters in the corridors and cafeterias of the internet". And the example he chooses happens to be about stylistics and measuring text similarity! Serendipitous indeed.

A couple of useful links/references (blog and academic):

Ted Underwood, "The differentiation of literary and nonliterary diction, 1700-1900", (Blog: The Stone and the Shell, 26 feb 2012)

- Ted Underwood diachronically compares literary text genres (poetry, drama, fiction) with non-fiction. Comparing word-frequency similarity, he finds that over time (1700 to 1900) the literary genres became less and less similar to non-fiction.

Interestingly, he also finds that, over that time period, non-fiction changed the most in relation to itself - that is, it changed the most as a genre. (He discusses some of the possible reasons for this so I won't repeat them here)

As Mark Liberman mentions, an obvious limitation is that this measure of similarity will depend on topic as well as style or diction.

I still need to go back to this later to look again at the stats and details.

Arvind Narayanan in "Is Writing Style Sufficient to Deanonymize Material Posted Online?" (Blog: 33 Bits of Entropy, 20 feb 2012) (blog also links to draft of forthcoming paper, "On the Feasibility of Internet-Scale Author Identification") looks at identifying blog authors:

"We were able to obtain about 2,000 pairs (and a few triples, etc.) of blogs, each pair written by the same author [...]. We added these blogs to the Spinn3r blog dataset to bring the total to 100,000. Using this data, we performed experiments as follows: remove one of a pair of blogs written by the same author, and use it as unlabeled text. The goal is to find the other blog written by the same author. We call this blog-to-blog matching. Note that although the number of blog pairs is only a few thousand, we match each anonymous blog against all 99,999 other blogs."

Take-aways:

- I discovered the term "stylometry", which is more specific and useful than what I had been calling "sort of like forensic linguistics".

- I have a lot of reading to do on stylistics (and stylometrics). Because basically all I had so far was Coupland (2007) Style: Language Variation and Identity, Cambridge University Press. [reviews: 1, 2]

AND THEN

Two minutes on Twitter means I come across this, from Google Research: Quantifying comedy on YouTube: why the number of o’s in your LOL matter, looking at the comments under YouTube videos. Variations in these "laughs" (lol, loool, aha, hahaha, etc... not to mention the recent comeback of "mwahaha") is exactly one of the things I was counting on looking at - my hypothesis is that the choice of one of these will strongly depend on the community context in which we are speaking. For example, we know that for some people, "lol" is totally uncool and would only be used ironically, in the form of "LOL" or "LULZ" in an otherwise capitalisation-free discourse.

The different types, and amount of, emphasis we might use (as the post describes, "e.g. capitalization (LOL), elongation (loooooool), repetition (lolololol), exclamation (lolllll!!!!!)") is another variable.

Google's research question is different: They're looking at to what extent this variation might be an indicator of the funniness rating of the video by the viewer. Though they admit that "funniness" is a difficult question (humour preference is subjective), they apparently have some human-annotated data to train classifiers with. Also, they took video tags (and, presumably, the video title) into account. And some audio-visual features. So, that sounds like fun.

Just when I'm wondering why I can't intern at Google, here are two things I need to look into:

1) What is a "passive-aggressive" ranking algorithm? Does it leave notes on the fridge rather than speaking to you, or does it secretly give items controversial rankings? Maybe I need to watch this.

2) "human-annotated pairwise ground truth" - I've assumed this refers to a human-annotated training corpus, but I haven't heard of "ground truth" before. Hmm.

And their references (copy-pasted):

“Opinion Mining and Sentiment Analysis,” by Bo Pang and Lillian Lee.

“A Great Catchy Name: Semi-Supervised Recognition of Sarcastic Sentences in Online Product Reviews,” by Oren Tsur, Dmitry Davidov, and Ari Rappoport.

“That’s What She Said: Double Entendre Identification,” by Chloe Kiddon and Yuriy Brun.

Plus, from the comments:

Biel, J-I. and Gatica-Perez, D. VlogSense: Conversational Behavior and Social Attention in YouTube. ACM Trans. Multimedia Comput. Commun. Appl. 2, 3, Article 1 (May 2010)

Biel, J-I., Aran, O., and Gatica-Perez, D. "You Are Known by How You Vlog: Personality Impressions and Nonverbal Behavior in YouTube".In [I think] ICWSMThe AAAI Press (2011) .

A couple of useful links/references (blog and academic):

Ted Underwood, "The differentiation of literary and nonliterary diction, 1700-1900", (Blog: The Stone and the Shell, 26 feb 2012)

- Ted Underwood diachronically compares literary text genres (poetry, drama, fiction) with non-fiction. Comparing word-frequency similarity, he finds that over time (1700 to 1900) the literary genres became less and less similar to non-fiction.

Interestingly, he also finds that, over that time period, non-fiction changed the most in relation to itself - that is, it changed the most as a genre. (He discusses some of the possible reasons for this so I won't repeat them here)

As Mark Liberman mentions, an obvious limitation is that this measure of similarity will depend on topic as well as style or diction.

I still need to go back to this later to look again at the stats and details.

Arvind Narayanan in "Is Writing Style Sufficient to Deanonymize Material Posted Online?" (Blog: 33 Bits of Entropy, 20 feb 2012) (blog also links to draft of forthcoming paper, "On the Feasibility of Internet-Scale Author Identification") looks at identifying blog authors:

"We were able to obtain about 2,000 pairs (and a few triples, etc.) of blogs, each pair written by the same author [...]. We added these blogs to the Spinn3r blog dataset to bring the total to 100,000. Using this data, we performed experiments as follows: remove one of a pair of blogs written by the same author, and use it as unlabeled text. The goal is to find the other blog written by the same author. We call this blog-to-blog matching. Note that although the number of blog pairs is only a few thousand, we match each anonymous blog against all 99,999 other blogs."

Take-aways:

- I discovered the term "stylometry", which is more specific and useful than what I had been calling "sort of like forensic linguistics".

- I have a lot of reading to do on stylistics (and stylometrics). Because basically all I had so far was Coupland (2007) Style: Language Variation and Identity, Cambridge University Press. [reviews: 1, 2]

AND THEN

Two minutes on Twitter means I come across this, from Google Research: Quantifying comedy on YouTube: why the number of o’s in your LOL matter, looking at the comments under YouTube videos. Variations in these "laughs" (lol, loool, aha, hahaha, etc... not to mention the recent comeback of "mwahaha") is exactly one of the things I was counting on looking at - my hypothesis is that the choice of one of these will strongly depend on the community context in which we are speaking. For example, we know that for some people, "lol" is totally uncool and would only be used ironically, in the form of "LOL" or "LULZ" in an otherwise capitalisation-free discourse.

The different types, and amount of, emphasis we might use (as the post describes, "e.g. capitalization (LOL), elongation (loooooool), repetition (lolololol), exclamation (lolllll!!!!!)") is another variable.

Google's research question is different: They're looking at to what extent this variation might be an indicator of the funniness rating of the video by the viewer. Though they admit that "funniness" is a difficult question (humour preference is subjective), they apparently have some human-annotated data to train classifiers with. Also, they took video tags (and, presumably, the video title) into account. And some audio-visual features. So, that sounds like fun.

Just when I'm wondering why I can't intern at Google, here are two things I need to look into:

1) What is a "passive-aggressive" ranking algorithm? Does it leave notes on the fridge rather than speaking to you, or does it secretly give items controversial rankings? Maybe I need to watch this.

2) "human-annotated pairwise ground truth" - I've assumed this refers to a human-annotated training corpus, but I haven't heard of "ground truth" before. Hmm.

And their references (copy-pasted):

“Opinion Mining and Sentiment Analysis,” by Bo Pang and Lillian Lee.

“A Great Catchy Name: Semi-Supervised Recognition of Sarcastic Sentences in Online Product Reviews,” by Oren Tsur, Dmitry Davidov, and Ari Rappoport.

“That’s What She Said: Double Entendre Identification,” by Chloe Kiddon and Yuriy Brun.

Plus, from the comments:

Biel, J-I. and Gatica-Perez, D. VlogSense: Conversational Behavior and Social Attention in YouTube. ACM Trans. Multimedia Comput. Commun. Appl. 2, 3, Article 1 (May 2010)

Biel, J-I., Aran, O., and Gatica-Perez, D. "You Are Known by How You Vlog: Personality Impressions and Nonverbal Behavior in YouTube".In [I think] ICWSMThe AAAI Press (2011) .

dimanche 12 février 2012

"Twitterology" in the New York Times

Ben Zimmer (of Language Log) writes in the New York Times on "Twitterology - A New Science?".

- Some of the possible uses of Twitter data: Linguistics, Sociology, Psychology...

- Advantages of Twitter mining: naturally-occurring data

- Recent work: "on the ground sentiment over the course of the Arab Spring"

- Criticisms of sentiment analysis: can moods be extracted from word selection?

mercredi 8 février 2012

L'aspect "Info-Comm"

Je fais cette année une double-cursus: M2 Sciences du Langage, M1 Sciences de l'Information et de la Communication.

L'idée, en faisant info-comm, autre que d'élargir les possibilités d'emploi (combien d'annonces demande une expérience en Sciences du Langage?!) de profiter d'être à la fac (au quel autre point de ma vie aurais-je la possibilité de faire les Sciences Humaines?) et de "faire plein trucs" (juste pour la variété), était d'avoir une autre perspective sur mon projet de recherche.

En info-comm on peut faire des choses qu'on ne pourrait pas faire en sciences du langage. On peut prendre des objets différents, et les examiner de différentes façons.

J'ai donc deux mémoires à faire. Sur plus ou moins le même objet, dans l'idée.

Tout de même, je cherche toujours la perspective vraiment "info-comm" (qui m'est quand même toujours un tout nouveau domaine).

Lors d'une réunion collective d'encadrement de mémoire lundi soir, une idée est plus ou moins sortie -- quelque-chose que j'avais considéré, que je ne pensais pas forcement étudier dans le cadre de mon mémoire Sciences du Langage, mais qui pourrait être plus intéressant dans une perspective Info-Comm.

Il s'agit de "catchphrases" (phrases fétiches) provenant des médias de masse tel que les séries télé, les publicités, etc.

Nous connaissances sûrement tous des exemples de ce genre de phénomène.

Deux viennent facilement en tête:

- Le mot "simples" (en anglais), venant du publicité "Compare the Meerkat" pour la société comparethemarket.com

Comme en anglais l'adjectif n'a pas besoin d'être accordé, la forme "simples" n'existe pas normalement (et ce n'est pas le genre d'erreur que fera un locuteur natif) donc tous les occurrences de cette forme (hors erreurs de non-natifs, etc.) sont, normalement, une référence plus ou moins directe à cette publicité.

- La forme du récit inspiré du séries du Canal+, "bref".

La narration fortement stylisée de cette émission a inspiré beaucoup de copies/parodies/références :

"Jsuis rentrer a la poste g atttendu encore attendu .. Un vieu ma parler mraconter sa vie puis g attendu ! Bref jetais a la poste ! "

(http://twitter.com/JuniorFavelas/status/166896775704219648)

"@Air_Pince "je peux prendre votre nom? -bien sur, alors c'est E***** - oui... -M-I-M-O-U-N -MIMOUN?!!" bref, j'ai pensé à toi "

( https://twitter.com/#!/Soktange/status/166885800150179840)

"Contacter Navigo Annuel par tel. Avoir un temps d'attente estimé à 2 min. Attendre plus de 6 minutes. Raccrocher. Bref, j'ai appelé Navigo."

( https://twitter.com/#!/toya_k/status/166893013631647746)

Sans entrer dans les thèmes de ces exemples (même si "emmerdements générales de la vie" est une thème courant dans le séries) nous pouvons voir une forme commune:

histoire + bref + j'ai (sommaire)C'est cette forme qui les distingue d'autres énoncés contenant le mot "bref".

Deux questions possibles:

1. Quand est-ce que ce phénomène (de faire ces reprises) a commencé? Comment a-t'il évolué? Est-ce que la forme s'est évolué, changé ou standardisé avec le temps? Quels sont les liens entre cette activité et le réseau social (de chacun des locuteurs)?

2. Comme distinguer des tweets avec un lien d'intertextualité au séries Bref d'autres tweets contenant le mot "bref"? Si une réponse à ceci est trouvé (quoi regarder?) et les attributs sont facilement traités et encodables (plutôt la ponctuation que l'anaphore, par exemple), l'hypothèse peut être testé par des algorithmes de fouille de données (tel que ceux qui sont disponible dans le logiciel Weka).

Donc, à suivre....

mardi 7 février 2012

Louise MERZEAU - Du signe à la trace : l'information sur mesure

Louise MERZEAU (2009) "Du signe à la trace : l'information sur mesure", Hermes n°53 Traçabilité et réseaux

Résumé, Article complet (pdf / html)

(Lecture pour un séminaire Comm', "Identité numérique et sociétés de l'information" avec MC)

Sujets :

Other links:

PRÉSENCE NUMÉRIQUE : LES MÉDIATIONS DE L’IDENTITÉ

Site personnel

Résumé, Article complet (pdf / html)

(Lecture pour un séminaire Comm', "Identité numérique et sociétés de l'information" avec MC)

Sujets :

- Différences entre "signe" et "trace"

- Extension de Watzlawick, "L'impossibilité de ne pas communiquer" -> Impossibilité de ne pas laisser des traces

- L'identité comme collection de traces

Other links:

PRÉSENCE NUMÉRIQUE : LES MÉDIATIONS DE L’IDENTITÉ

Site personnel

vendredi 3 février 2012

Méthodes spécifiques à l’internet

J'aurais bien aimé suivre le séminaire de Frank Rebillard, "Méthodes spécifiques à l’internet"... Mais je n'étais pas la seule - au moment des inscriptions, le cours était déjà complet.

Donc, 'y a qu'à piocher un petit peu dans la bibliographie...

Bibliographie indicative

BENKLER Y., 2009, La richesse des réseaux. Marchés et libertés à l’heure du partage social, Lyon : PUL [2006, The

Wealth of Networks. How Social Production Transforms Markets and Freedom, New Heaven / London : Yale University

Press.]

BEUSCART J.-S., CARDON D., PISSARD N., PRIEUR C., 2009, « Pourquoi partager mes photos de vacances avec des

inconnus ? Les usages de Flickr », Réseaux, n° 154, p. 91-129.

LESKOVEC J., BACKSTROM L., KLEINBERG J., 2009, « Meme-tracking and the dynamics of the news cycle »,

KDD’09 - International Conference on Knowledge Discovery and Data Mining, Paris

FOUETILLOU, G., 2008, « Le web et le traité constitutionnel européen. Ecologie d’une localité thématique compétitive »,

Réseaux, vol. 26, n° 147, pp. 229-257.

MARTY E., REBILLARD F., SMYRNAIOS N., TOUBOUL A., 2010, « Variété et distribution des sujets d’actualité sur

l’internet. Une analyse quantitative de l’information en ligne. », Mots – Les langages du politique, n° 93

RIEDER B., 2010, « De la communauté à l’écume : quels concepts de sociabilité pour le « web social » ? », tic&société,

Vol. 4, n° 1. [http://ticetsociete.revues.org/822]

ROGERS R., 2010, « Internet Research : The Question of Method », Journal of Information Technology and Politics, vol.

7, n° 2/3, pp. 241-260 [http://www.digitalmethods.net/]

Inscription à :

Articles (Atom)